Recurrent Neural Networks

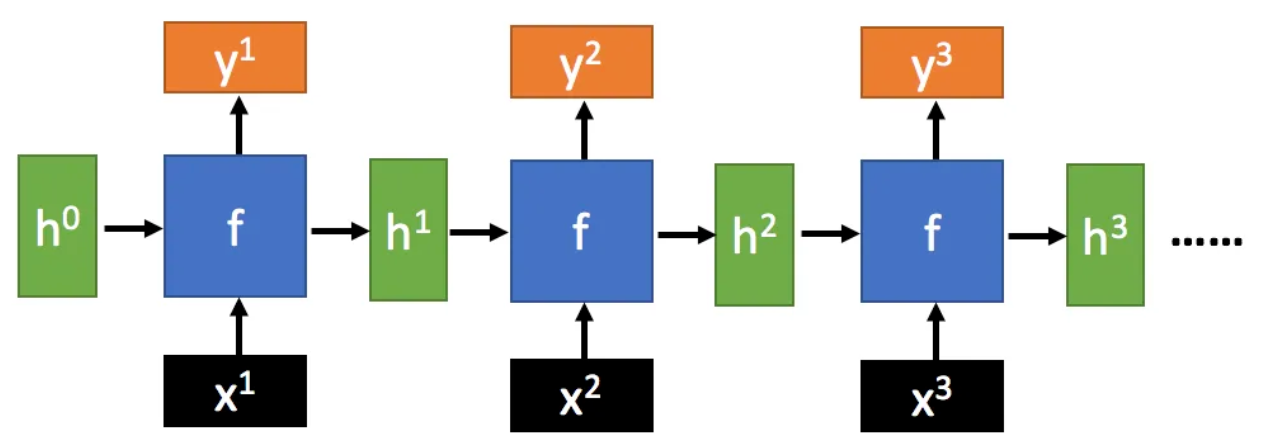

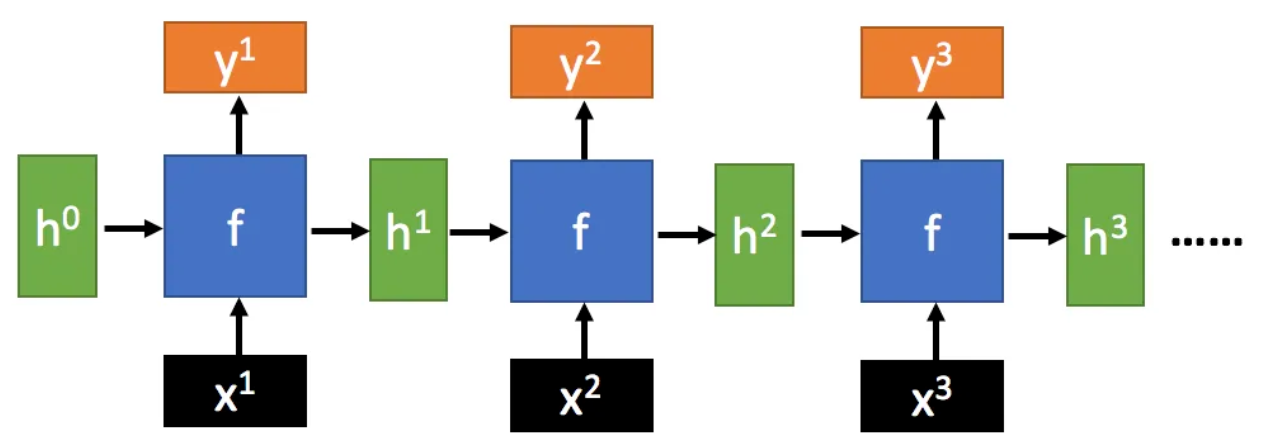

循环神经网络 (RNNs) 是一种具有循环结构的神经网络,

可以处理序列数据, 例如时间序列数据, 自然语言文本等.

当序列数据输入到 RNNs 中时, 每个时间步都会产生一个输出,

并将隐藏状态 (Hidden State) 传递到下一个时间步.

因此, 当改变输入序列的顺序时, RNNs 会产生不同的输出

(Changing sequence order will change output).

htyt=σ(Whht−1+Wixt+bh)=σ(Woht+by)

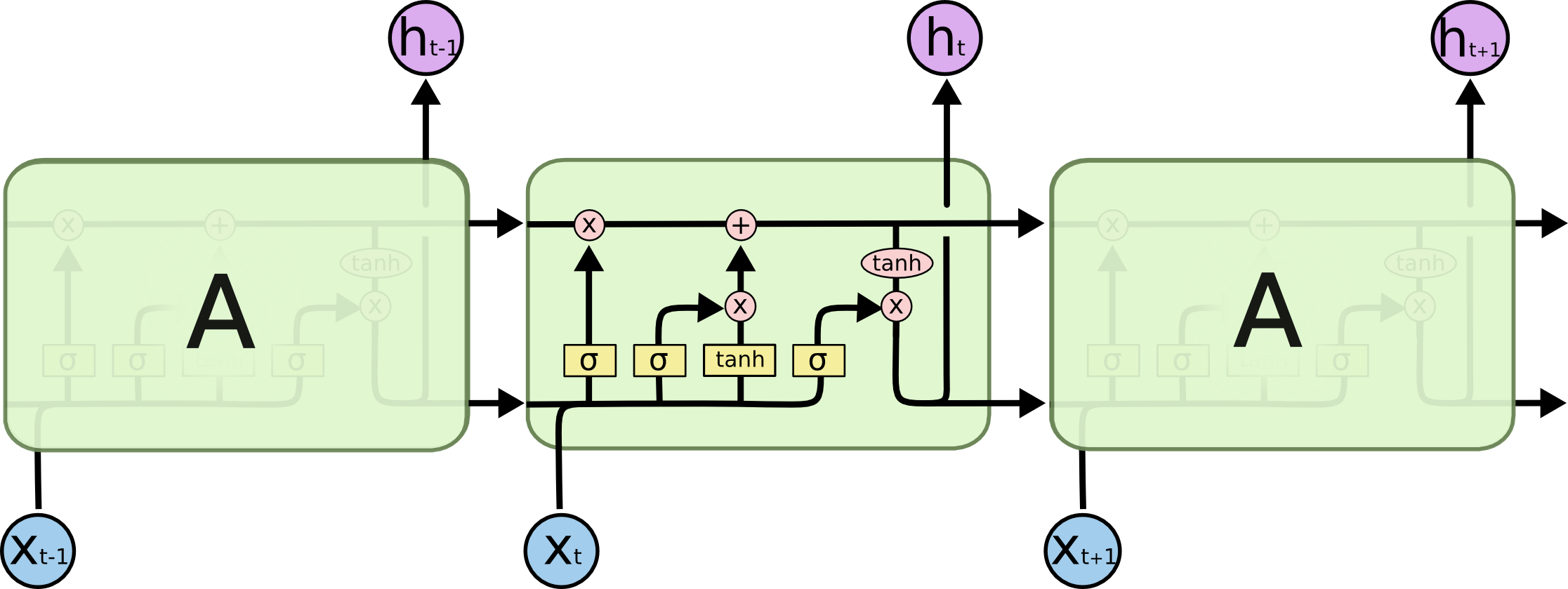

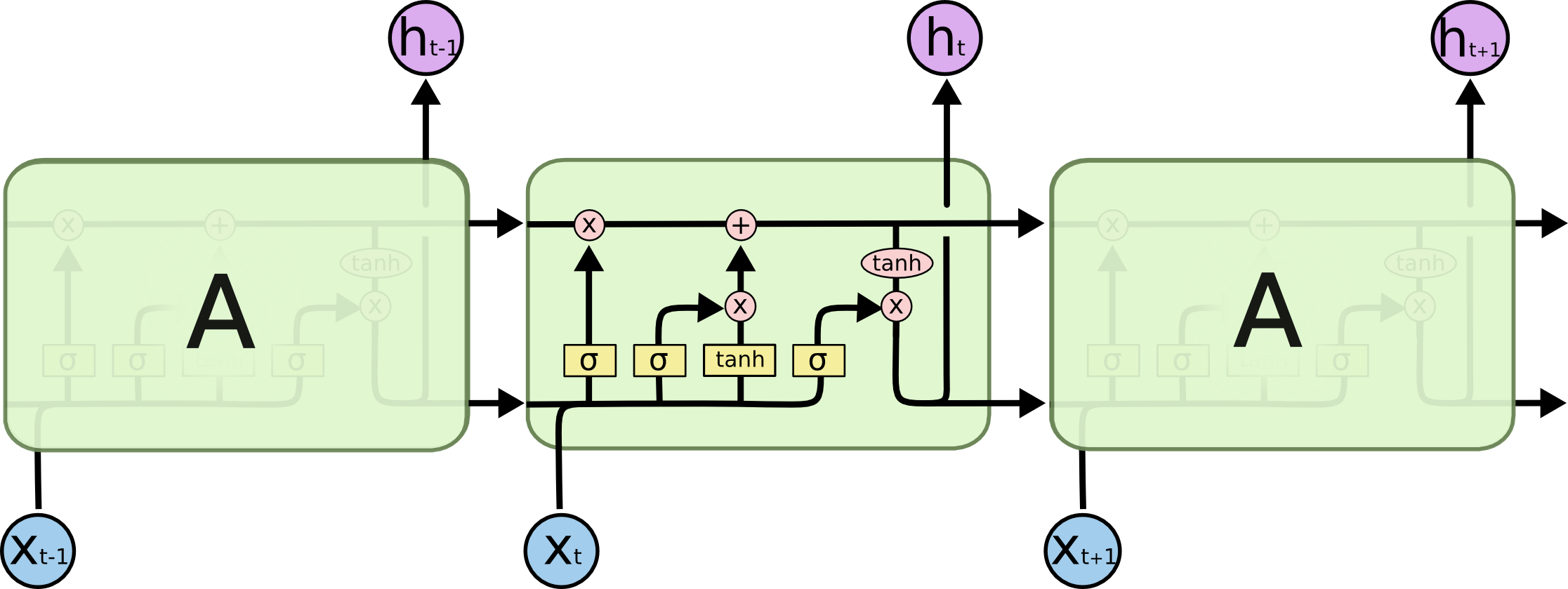

长短期记忆网络 (LSTM) 是一种特殊的 RNN,

通过引入门控机制 (Gate Mechanism) 来控制信息的流动,

解决了长序列训练过程中的梯度消失和梯度爆炸问题.

ftitC~tCtothtyt=σ(Wf⋅[ht−1,xt]+bf)=σ(Wi⋅[ht−1,xt]+bi)=tanh(WC⋅[ht−1,xt]+bC)=ft∗Ct−1+it∗C~t=σ(Wo⋅[ht−1,xt]+bo)=ot∗tanh(Ct)=σ(Wyht+by)